Digitaliseringsstyrelsen :

Nye vejledninger om forbudt brug af AI

Bemærk:

Dette er en praktisk oversigt til arbejdet og ikke juridisk rådgivning.

For detaljer og opdateringer bør I konsultere den relevante vejledninger fra EU-kommissionen/tilsyn.

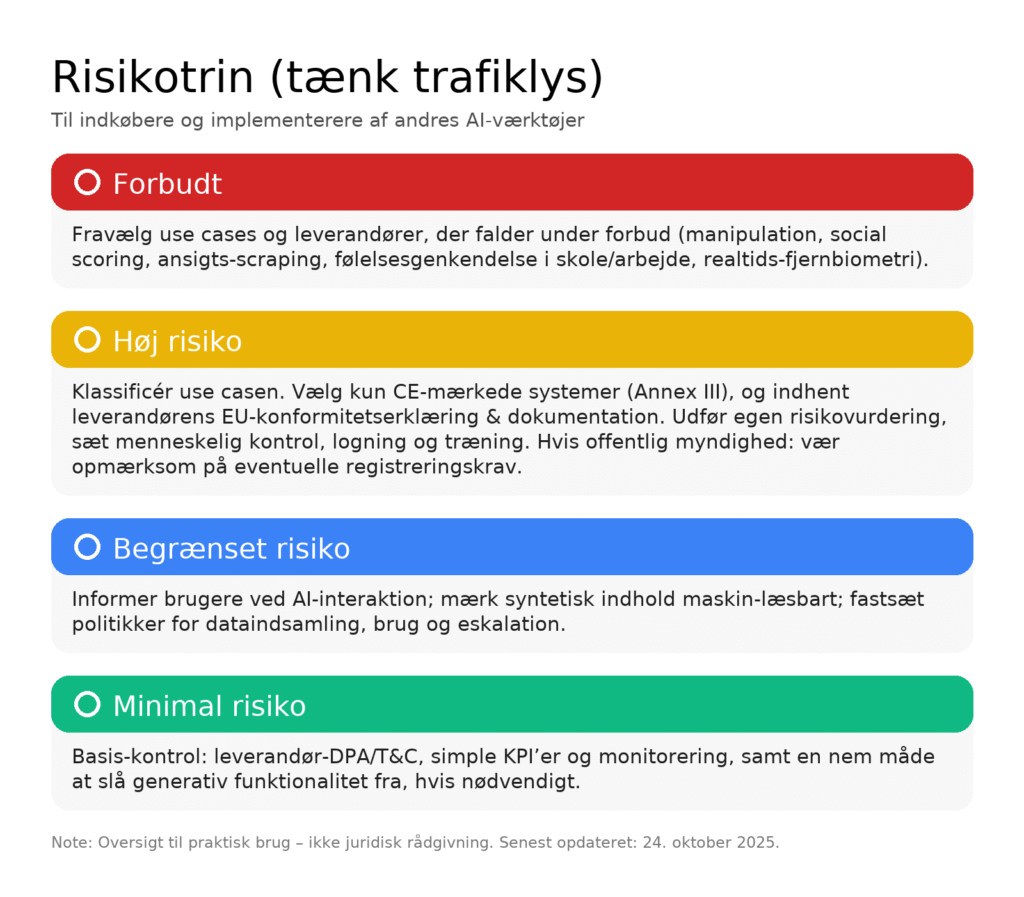

Risikotrin_implementering

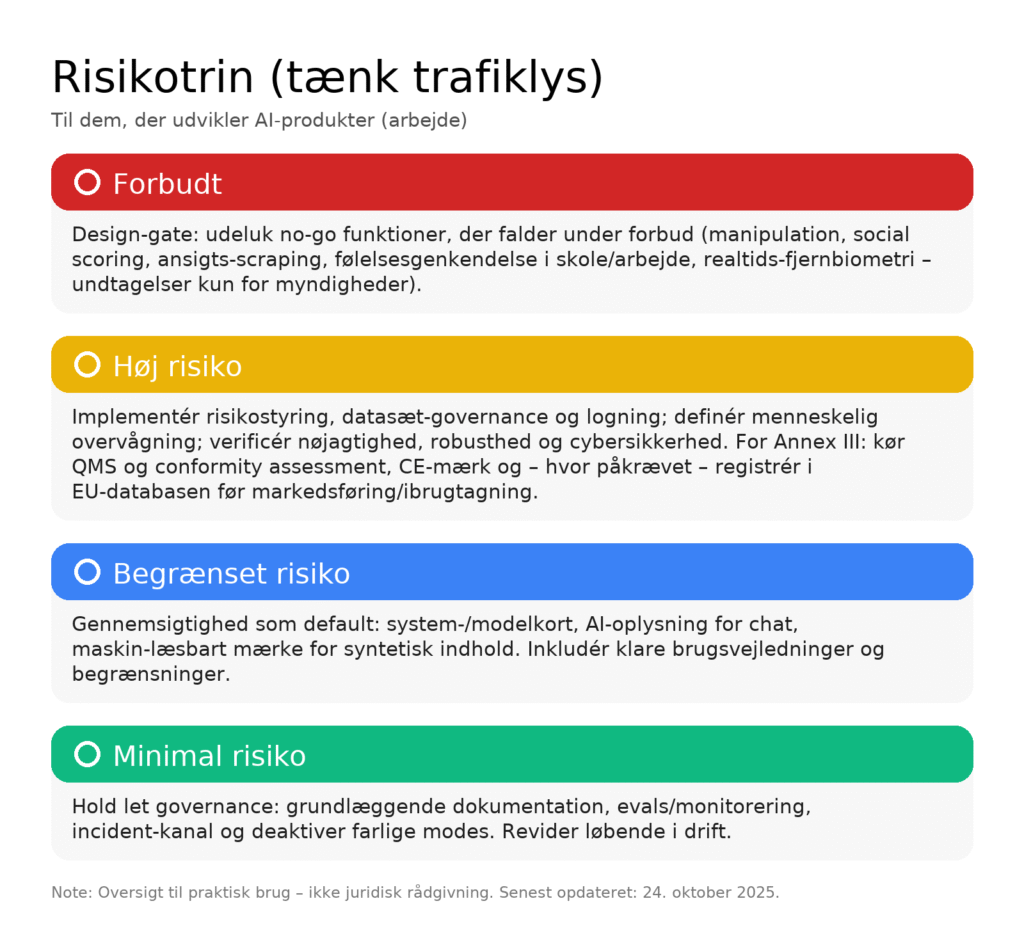

Risikotrin_udviklere

Hvad er formålet?

AI Act sætter fælles EU-regler efter risiko. Reglerne gælder både dem, der bygger (providers), og dem,

der implementerer/bruger (deployers) AI — også uden for EU, hvis systemet eller output anvendes i EU.

Tidslinje (hvornår gælder hvad?)

* Grundlæggende forbud og pligter: fra 2. februar 2025.

* Regler for GPAI/foundation-modeller: fra 2. august 2025.

* Hovedparten af høj-risiko-kravene: fra 2. august 2026.

* Visse yderligere klassifikations-/registreringskrav: fra 2. august 2027.

Risikotrin (tænk trafiklys)

* Forbudt (rød): manipulerende/deceptive AI, social scoring, ansigts-scraping til databaser,

følelsesgenkendelse i skole/arbejde, realtids-fjernbiometri i offentligheden (kun snævre undtagelser

for retshåndhævelse).

* Høj risiko (gul): AI i biometrisk identifikation (hvor lovligt), uddannelse (adgang/bedømmelse),

ansættelse/HR, kredit/offentlige ydelser, kritisk infrastruktur, retssystemet, migration/grænser m.fl.

* Begrænset risiko: ekstra gennemsigtighed — fx at chatbots oplyser, at de er AI; syntetisk

indhold/deepfakes skal mærkes maskin-læsbart.

* Minimal risiko: de fleste andre anvendelser — ingen ekstra AI Act-krav.

Hvad betyder det på jobbet?

* Hvis I bygger eller implementerer høj-risiko AI: I skal have risikostyring, data- og

dokumentationsgovernance, logning, menneskelig overvågning, samt sikre nøjagtighed, robusthed

og cybersikkerhed. De fleste Annex III-tilfælde kræver CE-mærkning og registrering i EU-databasen

før ibrugtagning.

* Hvis I leverer en GPAI/foundation-model: Fra 2. august 2025 kræves teknisk dokumentation,

brugsvejledning, opsummering af træningsdata m.m.; ekstra forpligtelser ved systemisk risiko.

* Hvis I bruger chatbots/syntetisk indhold: Brugere skal informeres, og kunstigt

genereret/manipuleret indhold skal mærkes maskin-læsbart.

Sanktioner (maksimum)

* Overtrædelse af forbud: op til €35 mio. eller 7 % af global omsætning.

*Andre alvorlige brud: op til €15 mio. eller 3 %.

* Vildledende oplysninger: op til €7,5 mio. eller 1 %. (Lavere lofter for SMV’er.)

Mini-tjekliste (hurtig start)

* Kortlæg jeres AI-use cases. Er noget forbudt? Hvis ja ® stop eller redesign.

* Klassificér risiko. Lander noget i typiske høj-risiko-områder (HR, uddannelse, kredit/ydelser,

biometrisk, ret, migration, kritisk infrastruktur)? Følg så høj-risiko-kravene.

* Bygger I GPAI? Planlæg dokumentation og processer til 2. august 2025.

* Genererer I syntetisk indhold? Sørg for AI-oplysning og maskin-læsbar mærkning.

* Opsæt governance-pakke: roller/ansvar, kvalitetsstyring (QMS), logning, hændelsesrapportering —

samt CE/registrering, hvor påkrævet.

info@aihub.dk